深圳市永芯易科技有限公司邀您參加2023世界電源產業博覽會

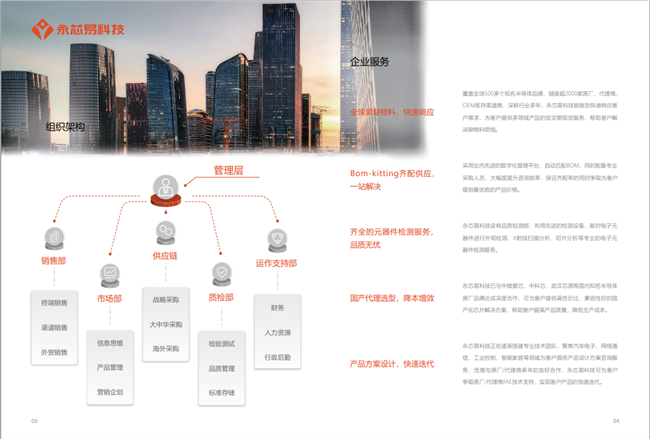

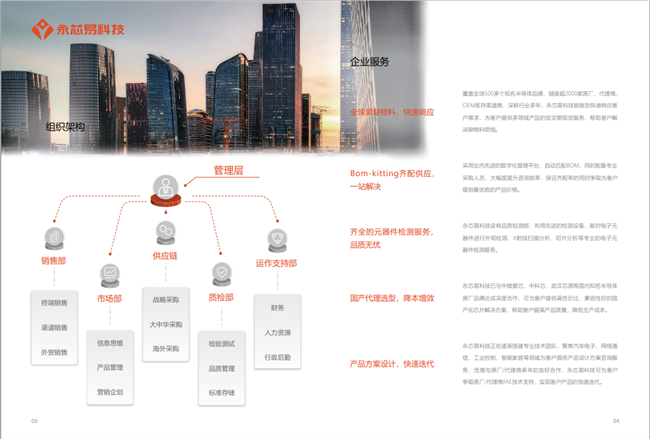

深圳市永芯易科技有限公司

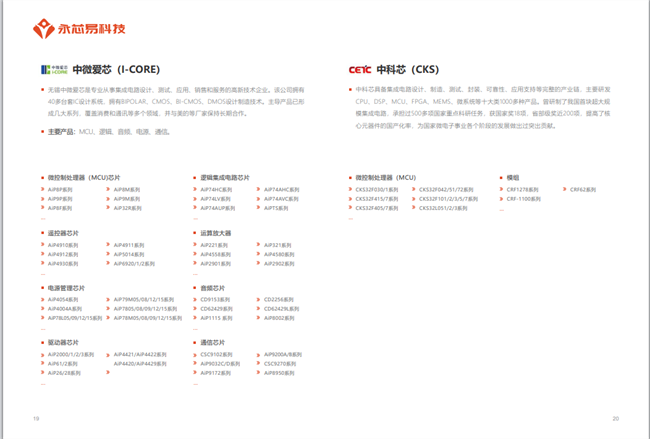

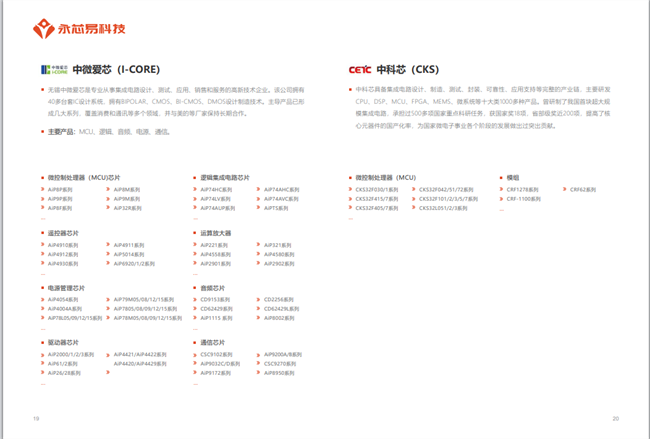

企業主營:電源IC、射頻IC、接口IC、數字信號處理器(DSP)、單片機(MCU)、場效應管(MOSFET)、單管(IGBT)、碳化硅(SIC)、運放、存儲、傳感器、可控硅等

展位號T29

深圳市永芯易科技有限公司

企業主營:電源IC、射頻IC、接口IC、數字信號處理器(DSP)、單片機(MCU)、場效應管(MOSFET)、單管(IGBT)、碳化硅(SIC)、運放、存儲、傳感器、可控硅等

展位號T29

詢價列表 ( 件產品)

哦! 它是空的。

哦! 它是空的。